Chatty(在瀏覽器上運行的本地大模型 AI 聊天工具) 簡介

Chatty 是一個瀏覽器上運行的本地大模型 AI 聊天工具,是一個利用 WebGPU 在瀏覽器中本地和私密地運行 LLM 的 Next.js 應用程序,這種方式消除了對伺服器端處理的需求,確保數據僅保留在本地電腦上,不會通過互聯網傳輸,從而實現將 LLM 的強大功能植入到瀏覽器,同時確保完全的隱私和離線功能。

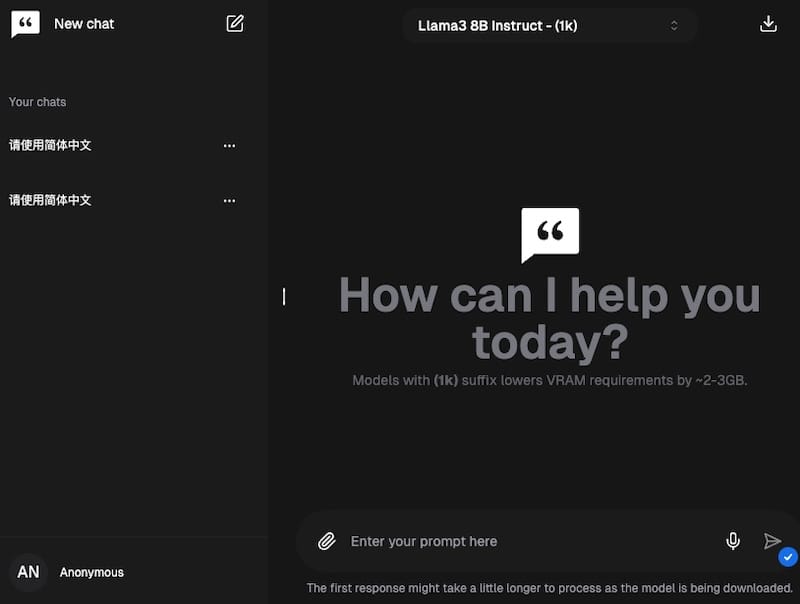

該工具支持流行的開源模型,如 Gemma、Llama2、Llama3 和 Mistral。讓我們能夠使用各種前沿的 AI 技術,同時該工具不僅僅是一個私人 AI 聊天工具,它提供了大量功能來增強我們的使用體驗。受到 Gemini 和 ChatGPT 等知名 AI 介面的啟發,該工具也擁有類似的直觀的用戶介面,為用戶提供了熟悉的使用方式。

該工具還有一個功能特性就是能夠通過 XenovaTransformerEmbeddings 和 MemoryVectorStore 處理和理解文件,包括 PDF 和非二進制文檔。這樣我們就可以上傳文件,並就內容向 AI 模型提問,同時我們的文檔將完全保留在本地,確保數據和隱私安全。

該工具還允許您添加自定義指令和記憶,使 AI 能夠提供更個性化和有針對性的響應。另外還可以將聊天記錄導出為 JSON 或 Markdown 格式,方便保存和分享對話內容。

該工具提供了語音輸入支持,允許我們使用自然語音與模型進行互動。如果您對響應不滿意,也可以快速重新生成,而無需重新輸入提示。

Chatty(在瀏覽器上運行的本地大模型 AI 聊天工具) 官網

如果要在本地設置和運行項目,請按照以下步驟操作:

1. 通過命令提示字元將存儲庫克隆到 PC 上的目錄:

git clone https://github.com/addyosmani/chatty

2. 打開資料夾:

cd chatty

3. 安裝依賴:

npm install

4. 啟動開發伺服器:

npm run dev

5. 瀏覽器中打開 localhost:3000 並開始聊天!